开云(中国)Kaiyun·官方网站 - 登录入口恰是明确区别透明和反光这两种类型的物理成因-开云(中国)Kaiyun·官方网站 登录入口

金磊 发自 杭州开云(中国)Kaiyun·官方网站 - 登录入口

量子位 | 公众号 QbitAI

天地苦机器东说念主看不清透明和反光物体久矣。

毕竟就连小动物以至东说念主,无意候一个不防备,都会搞笑地撞到干净的玻璃门……

不仅如斯,要是让机器东说念主提起透明的玻璃杯、反光的不锈钢物体,他们也会时常出现“俄顷看不清了”的情况。

这一切的问题,恰是出在了机器东说念主的眼睛——深度相机。

因为无论是基于结构光如故双目立体视觉的深度相机,它们的使命旨趣都是依赖物体名义对后光的踏实反射。

而透明材质会让后光胜仗穿透,高反光材质则会将后光漫反射到四面八方,导致传感器无法收受到有用的回波信号,从而产生无数缺失或空虚的深度值。

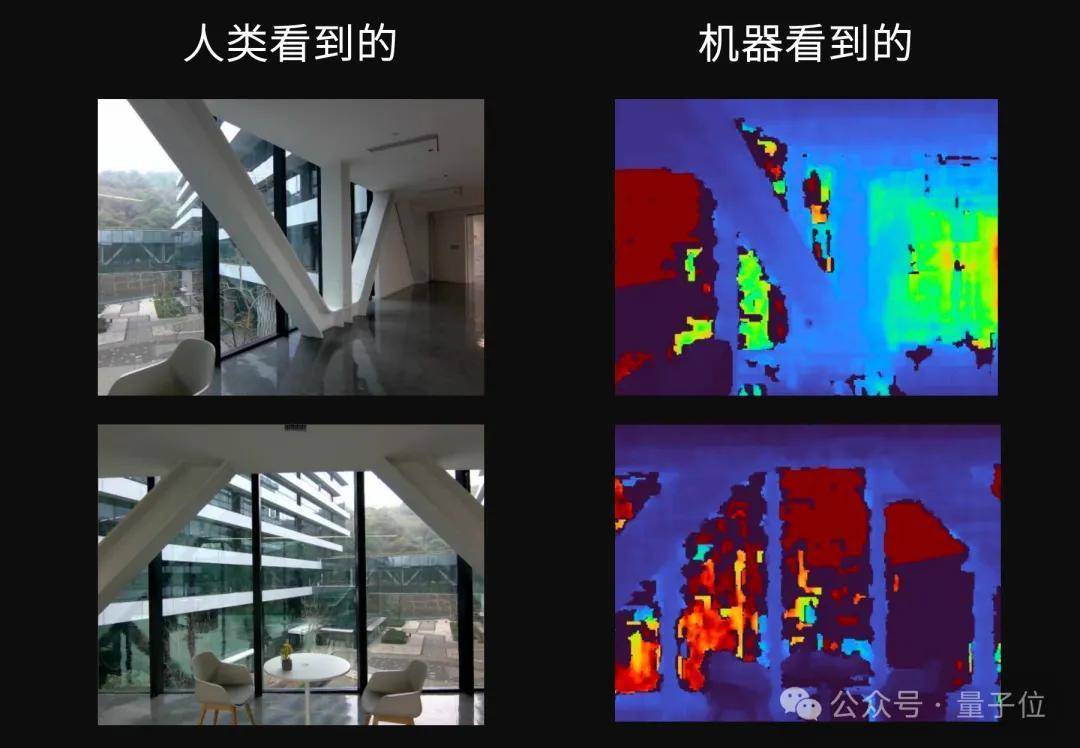

对比一下咱们东说念主类看到的场景和机器东说念主眼中的场景,就一目了然了:

绝不夸张地说,这类让机器东说念主睁眼看不清的问题,一直是费力它们安全地走进家庭、市场和病院等场景的Big Big Big Problem!

但面前,跟着一项新工夫的惨酷,机器东说念主的眼疾终于算是被治好了——

蚂皆集团的具身智能公司蚂蚁灵波科技(Robbyant),开源了寰球看得最流露的深度视觉模子,LingBot-Depth。

一样是上头两个场景,咱们胜仗来看下在LingBot-Depth加持下的约束:

也正因如斯,机器东说念主面前无论是捏取反光的不锈钢杯子,如故透明的玻璃杯,都是不费吹灰之力:

视频地址:https://mp.weixin.qq.com/s/y-5vx4MVlkucEMwxNQunJA

用一句经典歇后语来抒发这个feel,大约便是“老配头戴眼镜——不简单”。

照实不简单。

因为LingBot-Depth不仅解锁了“寰球看得最流露”的头衔,如故初度在不需要换硬件的条款下就能齐备的那种。

那么蚂蚁灵波到底是如何作念到的,咱们这就细扒一下论文。

咋就一下子能看清了?在许多非专科商榷中,透明和反光时常被视归并律,统称为视觉难点。

但要是从算法层面来看,它俩其实是两类截然有异、以至相悖的问题。

领先,透明物体的问题在于信息缺失。

玻璃险些不提供踏实的纹理,也不会像普通物体那样反射环境光,相机看到的,更多是配景的不竭。

关于深度模子来说,它既不知说念玻璃自己到哪儿才算罢了,也不知说念确切厚度和口头。

而反光物体的问题,正值相悖,是信息过载。

高反射率名义会把环境、光源、相机自己彻底映射进画面,导致归并物体在不同角度、不同时间下呈现完全不同的外不雅。

因此,模子很难判断,哪些像素属于物体,哪些仅仅倒影。

这也意味着,如果用一套赈济的假定去向理这两类问题,时时两端都作念不好。

LingBot-Depth的一个垂危假想念念想,恰是明确区别透明和反光这两种类型的物理成因,而不是把它们简单当成噪声。

为此,蚂蚁灵波团队意象了一个相等反直观的解法:

既然传感器在这些所在失效了,那这个失效自己,未便是一种最有劲的特征吗?

因为传感器输出的那些缺失区域,其实是一个自然的掩码(Natural Mask),起码不错告诉模子这块区域有问题。

受本年大火的MAE(Masked Autoencoders)的启发,团队便惨酷了一种名为Masked Depth Modeling(MDM,掩码深度建模)全新范式。

简单来说,LingBot-Depth在测验的流程中,会把深度图中那些自然缺失的区域动作掩码,然后要求模子仅凭完整的RGB彩色图像和剩余的有用深度信息,去脑补出被掩码遮住的那部分深度。

但这个流程也瑕瑜常具有挑战性的。

模子必须学会从RGB图像中挖掘出极其幽微的足迹,比如玻璃旯旮的折射畸变、反光名义的环境倒影、物体的抽象和暗影,然后将这些视觉高下文与已知的几何信息进行深度会通,才能作念出准确的估量。

为了齐备这一标的,LingBot-Depth在工夫架构上亦然作念了一些工致念念:

领先是纠合镶嵌的ViT架构。

模子取舍视觉Transformer(ViT-Large)动作骨干集聚,它会对输入的RGB图像和深度图分别进行分块(Patch Embedding),生成两组Tokens。

为了区别这两种模态,模子还引入了模态编码(Modality Embedding),告诉集聚哪些令牌来自激情,哪些来自深度。随后,通过自看重力机制,模子能够自动学习激情与深度之间的雅致对应相干,诞生起跨模态的纠合表征。

其次是智能掩码战术。

不同于MAE中完全立时的掩码,MDM的掩码战术更明智。它优先使用传感器自然产生的缺失区域动作掩码;关于部分有用、部分无效的深度块,则以高概率(如75%)进行掩码;如果自然掩码不够,才会补充一些立时掩码。

这种战术确保了模子恒久在处理最贫困、最确切的问题。

终末是ConvStack解码器。

在重建阶段,模子废弃了传统的Transformer解码器,转而取舍一个名为ConvStack的卷积金字塔解码器。

这种结构在处理密集的几何预计任务(如深度图)时,能更好地保留空间细节和范畴锐度,输出的深度图愈加流露、连贯。

此外,在数据采集与实验考证才智,团队还使用了奥比中光(Orbbec)的Gemini 330系列双目3D相机进行了无数确切场景的采集与测试。

这不仅保证了数据起头的万般性与确切性,也为模子在实验硬件平台上的部署提供了垂危救济。

通过这种形势,LingBot-Depth不仅学会了补全深度,更垂危的是,它将对3D几何的深入连气儿内化到了模子的“骨髓”里。

即使在推理时只给它一张单目RGB图片(莫得任何深度输入),它也能凭借学到的先验学问,估算出稀奇准确的深度图,展现出刚烈的泛化才智。

1000万数据真金不怕火出来的一个模子再刚烈,也离不开高质地、大领域的数据。

蚂蚁灵波团队构建了一套可膨胀的数据采集与合成的pipeline,其中,200万来自确切全国,100万来孤高保真仿真模拟;同期,还投合了开源数据,最终数据量达到了1000万。

在确切数据方面,团队假想了一套模块化的3D打印采集安装,不错生动适配多种商用RGB-D相机(如Orbbec Gemini、Intel RealSense、ZED等)。

他们走遍了住宅、办公室、市场、餐厅、健身房、病院、泊车场等数十种场景,系统性地采集了无数包含透明、反光、低纹理等挑战性物体真的切数据。这些数据掩饰了极其丰富的长尾场景,为模子的鲁棒性打下了坚实基础。

在仿真数据方面,为了模拟确切深度相机的成像残障,团队莫得简单地渲染完好的深度图,而是在Blender中同期渲染RGB图像和带散斑的红外立体图像对。再通过经典的半全局匹配(SGM)算法生成有残障的仿真深度图。

这种设施能高度归附确切传感器在靠近复杂材质时的失效模式。

值得看重的是,这套包含200万确切和100万仿真数据的雄壮数据集,是蚂蚁灵波团队近期计较开源的垂危钞票,旨在裁汰统统行业在空间感知领域的权衡门槛。

算法够改换,数据够硬核,这才有了LingBot-Depth隆起的性能发扬。

在多个泰斗的深度补全基准测试(如iBims、NYUv2、DIODE)上,它全面碾压了现时最先进的SOTA。

尤其是在最严苛的极点设定下(深度图大面积缺失并伴有严重噪声),LingBot-Depth的RMSE狡计比此前最佳的设施裁汰了特出40%。

除此除外,尽管模子是在静态图像上测验的,但它在视频序列上展现出了惊东说念主的时空一致性。

在一段包含玻璃大门、有镜子和玻璃的健身房、海洋馆贞洁的视频中,LingBot-Depth 输出的深度流不仅填补了原始传感器的大片缺乏,况且在统统视频流程中保持平滑、踏实,莫得任何精明或跳变。

为了考证LingBot-Depth 在确切全国中的价值,蚂蚁灵波团队将其部署到了一台确切的机器东说念主平台上。

这套系统由Rokae(节卡)XMate-SR5机械臂、X Hand-1忠良手和搭载了 LingBot-Depth 的 Orbbec Gemini 330 系列深度相机构成。

视频地址:https://mp.weixin.qq.com/s/y-5vx4MVlkucEMwxNQunJA

实验标的是捏取一系列对深度感知极具挑战的物体:不锈钢杯、透明玻璃杯、透明收纳盒和玩物车。

在20次捏取尝试中,使用LingBot-Depth的奏效用远高于使用原始深度数据。

缺欠,无意亦然一种上风

处理物理全国的感知难题,好的硬件自然垂危,但不一定非要死磕。

这大约便是LingBot-Depth给行业带来的一种启发。

因为在当年,当现存深度相机无法知足需求时,独一的出息时时是斥巨资更换更不菲、更专科的硬件。

而LingBot-Depth提供了一条软硬协同的旅途:它不错在不更换现存相机硬件的前提下,通过算法大幅擢升深度感知的鲁棒性与完整性。

它不错动作一个即插即用的算法模块,无缝集成到现存的机器东说念主、自动驾驶汽车或AR/VR开拓的感知链路中,以极低的本钱,显耀擢升其在复杂确切环境下的3D感知鲁棒性。

举例,在与奥比中光等硬件适配的流程中,团队考证了LingBot-Depth能够在其现存消耗级深度相机上齐备接近专科级传感器的感知约束。

这无疑将大大加快具身智能在家庭作事、仓储物流、生意零卖等场景的落地程度。

更垂危的是,蚂蚁灵波剿袭通达精神,还是开源了LingBot-Depth的代码和模子权重,并计较开源其雄壮的300万RGB-D数据集。

这一举动将极地面裁汰学术界和工业界在空间感知领域的权衡与开发门槛,有望催生更多改换运用,共同鼓动统统行业的上前发展。

除此除外,LingBot-Depth亦然有玄学意味在身上的:

无意候,缺欠自己便是一种上风。

你以为呢?

样式地址:

https://technology.robbyant.com/lingbot-depthGitHub地址:

https://github.com/robbyant/lingbot-depthHuggingFace地址:

https://huggingface.co/robbyant/lingbot-depth— 完 —

量子位 QbitAI · 头条号

怜惜咱们开云(中国)Kaiyun·官方网站 - 登录入口,第一时期获知前沿科技动态